Focus sur le choix des ancres des backlinks d'un...

De plus en plus de sites rencontrent des problèmes d’indexation, voire de désindexation. Avec, à la clé, des conséquences significatives comme une perte de trafic et/ou de revenus. Dans cet article, nous revenons en détail sur l’indexation pour tenter d’en comprendre le fonctionnement et de résoudre ces problématiques.

Pour aller plus vite :

Petit rappel sur l’indexation

“Indexation”, de quoi parle-t-on ? Il s’agit du processus par lequel les moteurs de recherche enregistrent les pages d’un site web dans leur base de données.

Une page indexée devient alors visible dans les résultats de recherche, plus ou moins loin suivant sa réponse aux critères de pertinence de l’algorithme.

Pour faire simple, lorsqu’une page n’est pas indexée, elle n’existe pas aux yeux de Google, et donc, des internautes.

Pour indexer une page, Google utilise des robots appelés “crawlers” ou “spiders”. Ces derniers explorent régulièrement le web pour détecter de nouvelles pages ou des mises à jour.

Une fois analysées, les pages jugées pertinentes sont enregistrées dans l’index de Google : elles sont indexées. Cette base de données sert ensuite à présenter aux internautes des résultats pertinents en fonction de leur requête.

🚨 Mais l’indexation, c’est comme les antibiotiques : c’est pas automatique.

Certaines conditions doivent être remplies côté site web :

Toutefois, il arrive que, même quand ces conditions sont remplies, les pages d’un site ne soient pas systématiquement indexées. Nous allons tenter de comprendre pourquoi dans la suite de cet article.

Une page non indexée n’apparaît pas dans les résultats de recherche, ce qui entraîne une baisse de visibilité pour le site et une chute de son trafic organique.

Cette baisse de trafic peut, à son tour, générer une diminution des revenus de l’entreprise si tout ou partie de son activité repose sur le référencement naturel.

Il est donc essentiel d’identifier et de corriger rapidement les problèmes d’indexation pour éviter des répercussions majeures sur l’activité de l’entreprise.

Du côté du netlinking, les conséquences sont tout aussi impactantes : une publication non indexée est une publication inutile.

Si la page n’est pas indexée, le lien intégré au contenu ne peut être pris en compte par Google et ne transmet donc aucune popularité au site de l’annonceur, ce qui réduit à néant le retour sur investissement (ROI) attendu par l’annonceur.

Google Search Console offre une vue d’ensemble de l’état d’indexation des pages d’un site.

Accessible via l’onglet Indexation > Pages, il permet de distinguer les pages déjà indexées de celles qui ne le sont pas.

En cas de pages absentes de l’index, Google Search Console propose une fonctionnalité pour demander leur indexation (on parle de “forcer” l’indexation).

Celle-ci vise à accélérer le processus “naturel” d’indexation de Google en informant manuellement le moteur de recherche de l’existence de ces pages.

Mais comme vous le verrez plus tard, ce n’est pas une solution miracle pour autant.

La méthode recommandée par Google n’est possible que si la Search Console est activée, une méthode réservée au webmaster du site. Autrement dit, impossible de contrôler l’indexation d’un site tiers avec cette méthode.

👉 Site: et/ou inurl:

Pour contrôler l’indexation d’une page, les opérateurs site: et inurl: sont encore beaucoup utilisés.

Concrètement, il s’agit de saisir dans la barre de recherche de Google inurl:adresse-de-votre-page, en remplaçant par l’URL exacte de la page que vous voulez contrôler.

Chez Develink, chaque publication effectuée via notre plateforme est monitorée, et nos analyses montrent que :

La méthode que Develink recommande est de renforcer le contrôle :

Exemple : site:https://www.develink.com/comment-choisir-backlinks-guide/ + “Comment choisir des backlinks de qualité ? Le guide pour débutants”

Ce double contrôle fonctionne pour le moment à 100%.

Si après ce double contrôle le test est toujours négatif 🤔 une analyse plus poussée s’impose pour identifier les causes de la non-indexation. Ça tombe bien, on en parle juste après.

👉 Troisième option : utiliser un outil tiers comme Ahrefs ou Semrush.

Il suffit simplement de mettre l’URL d’une page dans la barre de recherche de l’outil et de voir si celle-ci ressort au niveau des résultats.

Si la page démontre qu’elle se positionne au moins sur 1 mot-clé dans Google, c’est la preuve qu’elle est indexée.

Attention, Ahrefs ou Semrush fonctionnent avec leur propre crawler : le fait que ces outils connaissent la page ne suffit pas.

La preuve de l’indexation ne vaut que si la page atteint au moins une position. Cette méthode permet de démontrer l’indexation mais pas le fait que la page n’est pas ou plus indexée.

Jusqu’en septembre 2024, l’opérateur de cache Google permettait de voir comment Google interprétait et affichait une page web.

En tapant “cache:URL-de-la-page” dans la barre de recherche, il était possible d’accéder à la dernière version archivée par Google de la page, appelée “version cache”.

Un outil particulièrement utile pour analyser les éléments que Google avait enregistrés dans son index et identifier d’éventuels problèmes.

Google a toutefois décidé de désactiver cet opérateur de cache qu’il juge aujourd’hui obsolète.

Les deux alternatives au cache de Google sont l’outil d’inspection d’URL de la Google Search Console qui permet de voir comment le robot a interprété la page lors de sa dernière visite et la Wayback Machine qui permet de voir les versions archivées d’une page web*.

*Dans le cas de la Wayback Machine, il s’agit de la version que l’outil a lui-même archivée à une date donnée. Celle-ci peut être différente de celle de Google, mais a le mérite de donner un indice supplémentaire pour mener son enquête.

Certains signaux doivent vous alerter sur le fait que votre site subit peut-être des problèmes d’indexation.

Un trafic organique qui diminue de manière significative et sans raison apparente peut être lié à un problème d’indexation.

Si des pages importantes ne sont plus accessibles dans les résultats de recherche, elles ne génèrent plus de visites, et impactent donc directement le trafic global du site.

Plus significatif encore, un nombre de mots clés positionnés qui baisse fortement et caractéristique d’un problème de positionnement voire d’indexation de vos pages.

Pas d’indexation = Pas de jus = Pas de position = Pas de clics = Pas de trafic

Il faut avoir le réflexe de regarder dans la Google Search Console les causes qui pourraient empêcher l’indexation de ces pages.

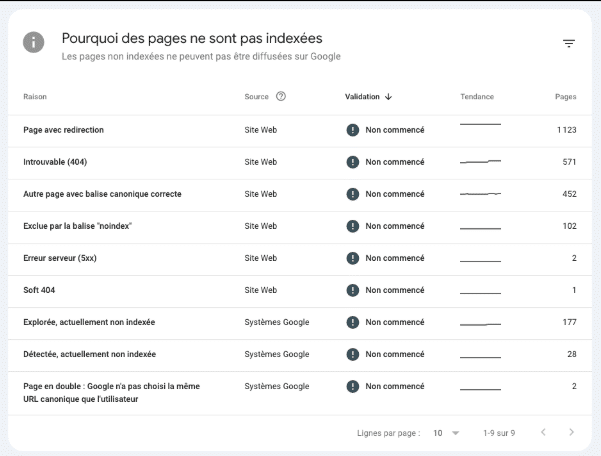

Dans la Google Search Console, vous avez accès à une section “Explorée, actuellement non indexée” qui vous indique les pages que le robot a exploré mais a décidé de ne pas diffuser.

Une augmentation importante du nombre de pages dans cette section, surtout s’il s’agit de pages importantes, doit vous alerter sur un éventuel problème d’indexation.

Dans le rapport, vous avez également accès à d’autres sections comme “Introuvable 404”, “Exclue par la balise “noindex” ou encore “Autre page avec balise canonique correcte”. Il est utile de vérifier régulièrement que les pages qui figurent dans ces sections y sont à juste titre.

Lorsque les nouvelles pages mettent beaucoup de temps à apparaître dans les résultats de recherche, cela peut indiquer une difficulté pour les robots de Google à explorer ou indexer le site.

Cela peut être lié à une mauvaise configuration technique ou à une faible autorité du domaine (si le site est neuf par exemple), qui limite la fréquence de crawl.

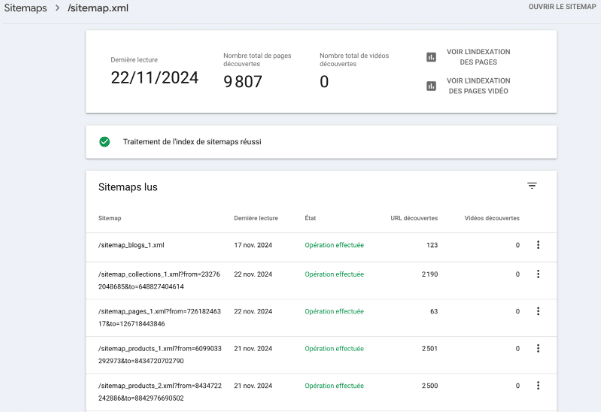

Le sitemap XML est un fichier qui répertorie les URLs importantes d’un site pour aider les moteurs de recherche à les explorer et les indexer plus facilement.

Sa création se fait souvent de manière automatique via les CMS comme WordPress ou les plugins SEO (Yoast ou Rank Math SEO ont tous deux une fonctionnalité qui permet de générer un sitemap et de le mettre à jour automatiquement ).

Pour les sites qui ont beaucoup d’URLs, il garantit que toutes les pages pertinentes soient bien prises en compte par les moteurs de recherche, même celles qui ne sont pas reliées directement entre elles via des liens internes.

Le plan de site peut être soumis à Google via l’onglet “Sitemaps” de la Google Search Console et ajouté au fichier robots.txt (voir juste après) pour faciliter encore plus sa prise en compte par les moteurs de recherche.

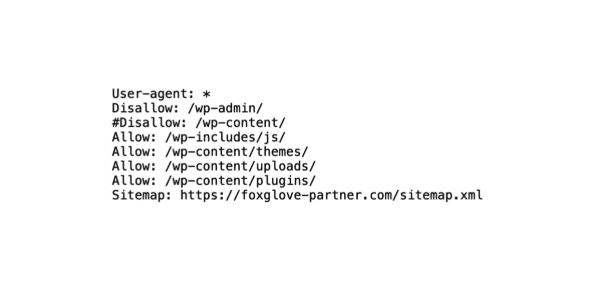

Le fichier robots.txt donne les consignes aux robots des moteurs de recherche sur les sections du site à explorer ou à ignorer, ce qui permet d’optimiser le budget de crawl (la quantité de ressources que Google alloue à l’exploration d’un site).

Exemple d’un fichier robots.txt “classique” généré par WordPress

Autrement dit, il y a tout intérêt à favoriser l’exploration de Google aux pages importantes de votre site plutôt que de la “gaspiller” sur des pages à faible intérêt.

En parallèle, ce fichier vous permet aussi de mieux contrôler l’indexation du site en bloquant par exemple l’accès à des fichiers confidentiels ou qui n’ont pas vocation à être rendus publics.

⚠️ Il arrive parfois que le fichier robots.txt soit mal configuré ou comporte des directives erronées qui peuvent bloquer l’accès à certaines pages importantes du site.

Explication des directives à travers un exemple :

Le problème survient si vous remarquez une ligne “Disallow : /page-stratégique”, car cela signifierait que vous bloquez l’accès à cette page à tous les moteurs de recherche.

Si votre site comporte beaucoup d’URLs, vous pouvez utiliser l’outil Screaming Frog qui vous fera remonter la liste de toutes les pages bloquées par le robots.txt. Vous pouvez également les visualiser dans l’onglet “Indexation” > “Bloquée par le fichier robots.txt” de la Google Search Console.

En parallèle du robots.txt, trois autres directives se trouvant cette fois-ci dans la page elle-même permettent d’analyser et de contrôler la manière dont un contenu sera pris en compte dans les résultats de recherche : l’en-tête X-Robots-Tag et l’attribut data-nosnippet.

👉 La première est utilisée pour donner des instructions aux moteurs de recherche concernant des pages ou des fichiers spécifiques, images ou documents PDF, qui ne peuvent pas utiliser de balises meta.

Par exemple, le fait d’indiquer “X-Robots-Tag: noindex” dans la réponse HTTP informe les moteurs de recherche de ne pas indexer la page et de ne pas l’afficher dans les résultats de recherche.

👉 La seconde, l’attribut data-nosnippet, est utilisé dans le code HTML pour indiquer que certains éléments du contenu d’une page ne doivent pas être utilisés dans les extraits (les « snippets ») affichés dans les résultats de recherche.

Ajouter une directive data-nosnippet à un élément HTML signifie donc que vous ne souhaitez pas que cet élément apparaisse au niveau des extraits.

Ces deux paramètres offrent donc un moyen supplémentaire de contrôler ce qui est exploré et ce qui est indexé.

👉 La troisième et probablement celle qui bloque le plus souvent l’indexation n’est autre que la directive <meta name=”robots” content=”noindex”>, communément appelée balise noindex.

Nous y reviendrons en détail dans la partie dédiée aux raisons techniques et balises à contrôler.

Les temps de chargement d’un site impactent à la fois l’expérience utilisateur (UX) et le référencement naturel d’un site.

De plus en plus, Google valorise les sites qui offrent une bonne expérience utilisateur, avec des pages qui se chargent rapidement, un design responsive et une navigation fluide.

Pour mesurer et améliorer vos temps de chargement, vous pouvez utiliser l’outil PageSpeed Insights qui vous livre une série d’optimisations possibles comme la compression de fichiers ou l’optimisation des paramètres de mise en cache.

L’hébergement peut également jouer un rôle dans le temps de chargement d’un site. Un hébergement adapté garantit une meilleure stabilité et des temps de réponse plus rapides.

L’importance d’optimiser la version mobile de son site ne date pas d’hier, et aujourd’hui Google privilégie la version mobile dans son exploration (d’où l’appellation Mobile-First Index ou indexation orientée mobile).

En d’autres termes, il donne la priorité à l’indexation des pages mobiles sur les autres.

À nouveau, une bonne expérience utilisateur sur mobile se caractérise par des temps de chargement rapides, un design responsive et une navigation accessible.

Autant de critères auxquels il est important d’apporter le plus grand soin quand on sait que Google prend en compte ces éléments dans son classement.

Le maillage interne est essentiel pour favoriser l’indexation d’un site car il permet aux robots de Google de naviguer efficacement entre les pages.

Il est important que toutes les pages importantes du site soient liées entre elles et que leur contenu soit facilement accessible.

L’optimisation du maillage interne passe aussi par la pertinence des textes d’ancrage et un nombre cohérent de liens sur chaque page pour éviter de diluer l’autorité des URLs stratégiques.

Screaming Frog vous permet d’identifier rapidement les pages orphelines sur votre site (celles qui ne sont reliées à aucune autre page) et de les intégrer dans votre maillage interne afin d’en faciliter l’exploration, et donc l’indexation par les moteurs de recherche.

Les backlinks de qualité provenant de sources fiables augmentent la crédibilité de votre site et contribuent à favoriser son exploration par les robots de Google.

En investissant dans la création de backlinks, vous renforcez la notoriété et la pertinence de votre site, ce qui peut améliorer son classement dans les résultats de recherche.

Plus votre site est perçu comme digne de confiance, plus il sera indexé rapidement et efficacement par Google.

Produire du contenu de qualité est un autre moyen de faciliter l’indexation des pages de son site.

Parce que Google privilégie les sites qui apportent une réelle valeur ajoutée aux utilisateurs, il est important de proposer un contenu original, bien structuré et pertinent, et d’éviter au maximum les contenus dupliqués ou de qualité médiocre.

Si vos contenus répondent aux critères de pertinence de Google en termes d’originalité, de valeur ajoutée, d’expertise et de fiabilité, cela l’incitera à explorer davantage votre site et à en indexer ses pages.

Vous pouvez demander manuellement l’indexation d’une page en vous rendant dans l’onglet Inspection d’URL de votre Search Console.

Pour ce faire, il vous suffit de renseigner l’URL de la page que vous souhaitez indexer et de cliquer sur Demander l’indexation.

Google vérifiera si l’URL est accessible et l’ajoutera à son processus d’exploration, ce qui peut accélérer son indexation. Cette fonctionnalité est particulièrement utile pour des pages importantes ou des mises à jour récentes que vous souhaitez faire indexer rapidement.

Cependant, il est déconseillé de forcer systématiquement l’indexation via cette méthode pour vos nouvelles pages. Google dispose en effet de ses propres critères d’exploration et d’indexation basés sur la qualité du contenu et la structure du site.

Utiliser cette fonctionnalité de manière excessive peut non seulement être inefficace, mais également envoyer un mauvais signal à Google en lui donnant l’impression que votre site est mal structuré ou qu’il nécessite constamment des corrections manuelles.

De manière générale, nous vous conseillons de laisser Google gérer l’exploration naturelle de vos pages, et de réserver cette fonctionnalité manuelle pour des contenus spécifiques ou urgents.

L’indexation d’un nouveau site par Google peut prendre plusieurs semaines.

Il n’y a pas de solution “miracle” pour accélérer le processus, si ce n’est suivre les recommandations évoquées plus haut dans l’article comme le fait de soumettre votre plan de site via la Google Search Console ou encore de vérifier la syntaxe et les directives de votre fichier robots.txt.

Nous l’avons vu, le fichier robots.txt permet d’autoriser ou de bloquer l’accès des moteurs de recherche à certaines pages de votre site.

Le fait qu’une ou plusieurs de vos pages ne soient pas indexées peut s’expliquer par la présence d’une règle restrictive dans le fichier.

Le fichier .htaccess est un fichier de configuration utilisé par les serveurs Apache pour gérer l’accès à certaines parties de votre site web.

Il permet, par exemple, de restreindre l’accès à un répertoire spécifique en exigeant un login et un mot de passe pour y accéder. Cette protection peut empêcher l’affichage de certaines pages, rendant leur exploration par les robots impossible.

La balise « noindex » a pour effet d’empêcher l’indexation de certaines pages de votre site par les moteurs de recherche, ce qui peut être utile si vous ne souhaitez pas que certaines URLs apparaissent dans les résultats ou pour faire des tests d’intégration par exemple.

Vous pouvez facilement vérifier la présence d’une balise noindex sur vos pages en inspectant leur code source ou directement sur votre CMS. Sur WordPress, il s’agit d’une option “Oui” ou “Non” dans la section “Visibilité par les moteurs de recherche”.

Pendant 25 ans, Google a cherché à indexer tout le contenu web pour offrir le plus de matière possible aux internautes. Cette stratégie avait du sens à une époque où la production de contenu était limitée, tout du moins au regard de ce que nous connaissons aujourd’hui.

En effet, avec l’arrivée des grands modèles de langage (Large Language Model – LLM), la production de contenu a explosé. Désormais accessible à tous, cette dernière ne connaît aucune limite, d’autant plus qu’elle se base sur ce qui existe déjà sur le web. Dans ce contexte, une indexation “massive” devient de moins en moins pertinente.

Google a dû renforcer ses filtres pour privilégier les contenus utiles et de qualité, En un mot : authentiques. Les sites ne respectant pas ces critères, de plus en plus sévères, se retrouvent alors confrontés à ce phénomène récent de problème d’indexation, voire de désindexation.

Se focaliser uniquement sur les moteurs de recherche au lieu de penser à ses utilisateurs est l’une des principales erreurs à éviter.

Autrement dit : publier du contenu dans l’unique but de plaire à Google, sans répondre aux attentes réelles des internautes.

Google peut désormais évaluer la pertinence d’une page en fonction de signaux de satisfaction et d’engagement de la part des internautes, comme le temps passé sur la page, les clics, le scroll…

Pour envoyer les bons signaux et prouver l’utilité de ses contenus, il est essentiel de concentrer sa stratégie sur la qualité et la pertinence, en adoptant les principes de l’E-E-A-T (Expérience, Expertise, Autorité, Fiabilité) sur chacune des pages.

Et si vous avez encore besoin d’être convaincus, c’est le Search Liaison de Google Danny Sullivan qui le dit lui-même : “S’il vous plaît, je vous supplie d’arrêter de vous concentrer sur des éléments de contenu spécifiques. Il ne s’agit pas de savoir si une table des matières ou le fait de dire que quelqu’un est un “expert” est un signal spécifique. C’est que ces choses pourraient indiquer une tendance à faire trop de choses “pour les montrer à Google” qui enlève au simple fait d’être un bon site pour les gens – ce que Google veut récompenser.”

Responsable Editorial & Référencement SEO

Après avoir accompagné plusieurs dizaines d’entreprises dans leur stratégie de contenus web, Chloé Ribot occupe aujourd’hui le poste de Responsable Editorial & Référencement SEO chez Develink. Sa mission principale est d’améliorer la visibilité des clients de l’agence en les aidant à développer leur image de marque et à produire des contenus éditoriaux pertinents.